やりたいこと

StableDiffusion AUTOMATIC1111およびForgeでanytestを使用します。

また以下の記事で構築したAMDのGPU(DirectML)の環境でも動作することを確認しています。

anytestとは

anytestとは一つのモデルで線画やシルエットから画像を生成したり、画像の一部を書き直したりできるControlNetのモデルです。

anytestのインストール方法

AUTOMATIC1111とForgeでインストール方法が異なるのでご注意ください。

ControlNetのインストール

AUTOMATIC1111

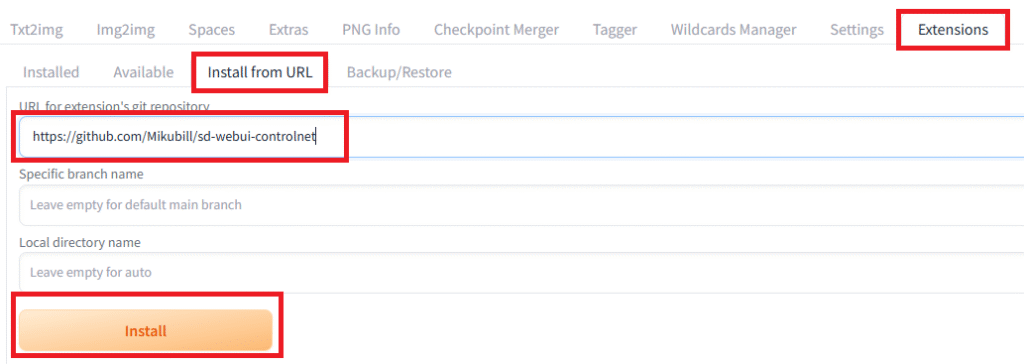

Extensionタブ内の”install from URL”タブを開きます。

URL for extension’s git repositoryに以下のURLを入力してinstallをクリックします。

Extensionのインストールに失敗する場合は以下のページを参照してください。

インストールが完了したらStableDiffusionを再起動します。

インストールやインストールあと最初の起動にとても時間がかかることがあります。

ただしくインストールできると再起動後にSeedの下にControlNetのGUIが表示されます。

私の環境だと再起動後にControlNetのGUIが表示されませんでした。

もう一度再起動したら表示されました。

Forge

ForgeにはもとからControlNetを組み込まれているのでインストール不要です。

モデルのダウンロード

モデルは以下のページからダウンロードします。

ファイルはCN-anytest_v4-marged.safetensorsが無難なようです。

モデルのインストール

AUTOMATIC1111

ダウンロードしたモデルを以下のフォルダに置きます。

ルート\extensions\sd-webui-controlnet\models

Forge

ダウンロードしたモデルを以下のフォルダに置きます。

ルート\\models\ControlNet

上記でインストール完了です。

ControlNetの使用

ForgeのGUIで説明します。

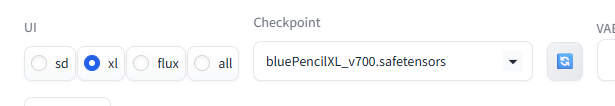

StableDiffusionXLのモデル(checkpoint)を選択します。

Forgeの場合はUIもxlにします。(画像生成に失敗したらsdにして試してください。)

StableDiffusionXLのモデルは大体名前にXLと入っています。

私はbluePencilXL_v700.safetensorsを使用しました。

ControlNetのメニューをクリックして開きます。(AUTOMATIC1111ではControlNet vXXXXXという表示です。)

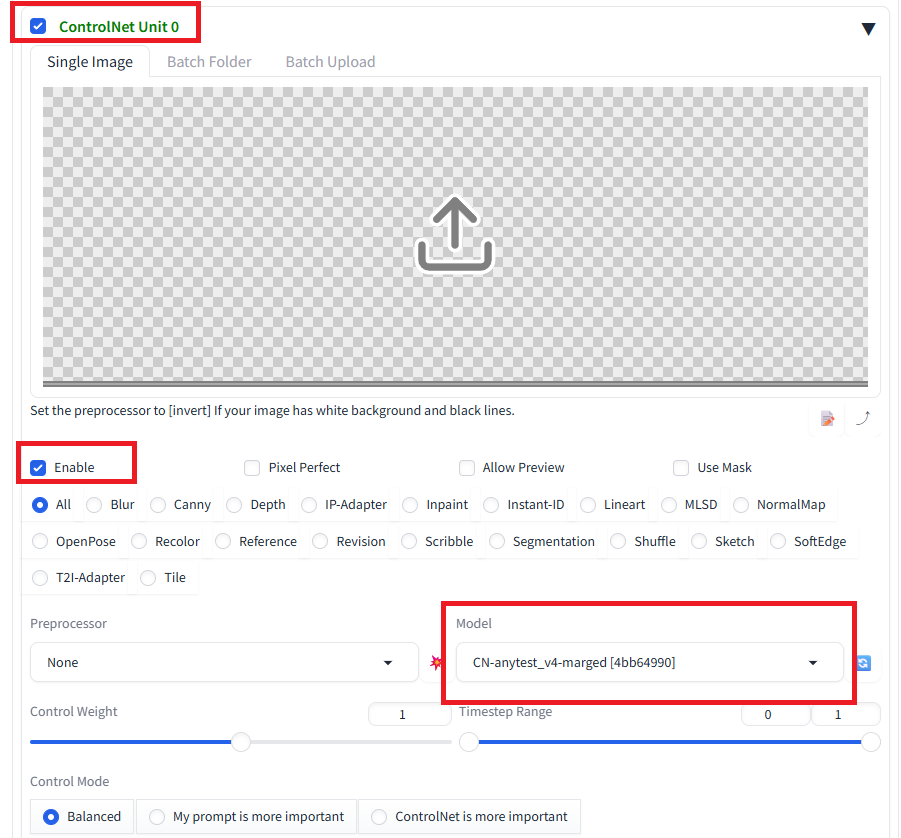

”ControlNet Unit 0”、”Enable”にチェックを入れます。

Modelにダウンロードしたanytestのモデルを選択します。

(モデルがプルダウンに表示されない場合は、右側の更新ボタンをクリックします。)

以下のGUIに使用する画像をドラッグアンドドロップで設定します。

後は通常の画像生成と同様にPrompt(とNagativePrompt)を入力してGenerateをクリックします。

結果

anytestを使用することができました。

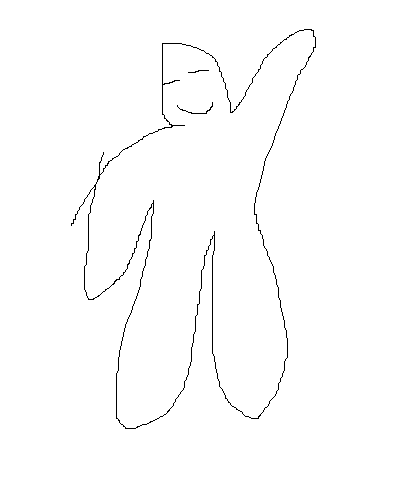

下の例を見ていただくとわかるようにかなり好意的に解釈して画像を生成してくれます。

また生成画像の絵柄はモデルに依存するようです。

生成例

入力画像:

モデル:bluePencilXL_v700.safetensors(アニメ調画像向け)

プロンプト:a girl , blue skirt, white shirt, yellow hair, from front

出力:

トラブルシューティング

AttributeError: ‘NoneType’ object has no attribute ‘shape’

実行時に”AttributeError: ‘NoneType’ object has no attribute ‘shape’”が出力され失敗することがります。

このエラーは画像生成のモデル(ControlNetではなく上で設定するcheckpoint)がSDXL用でないときに出力されます。

画像生成モデルがSDXL用であるか確認してください。

コメント